Velocità di riproduzione:

Come sappiamo, la gestione di un sito richiede diverse aree di competenza. Una di queste, in termini di traffico, è la gestione della SEO. Ovvero quell’insieme di pratiche finalizzate all’ottimizzazione di un sito internet all’interno dei motori di ricerca.

La dipendenza dai motori è indiscutibile. In alternativa, si correrebbe il rischio di perdersi tra i quasi due miliardi di siti che popolano la rete.

Tuttavia, sia la presenza in rete che nei motori di ricerca non è abbastanza. Occorre quindi attuare strategie che permettano di indirizzare traffico verso il proprio sito. Una volta raggiunto questo obiettivo, occorre quantomeno mantenerlo se non aumentarlo.

Ma cosa accade quando, invece, il traffico di un sito crolla? A questa risposta ha tentato di rispondere Daniel Waisberg, Search Advocate in Google. Almeno per quanto riguarda il motore di proprietà di Alphabet Inc.

Le 5 principali cause dei cali di traffico della Ricerca Google

Waisberg individua cinque principali cause, ovvero: Problemi tecnici e di sicurezza, azioni manuali, modifiche algoritmiche e diminuzione dell’interesse di ricerca.

Andando per ordine, le cause legate ai problemi tecnici e di sicurezza sono riconducibili, fondamentalmente, alla gestione del sito. Infatti se il crawler di un motore ha difficoltà a scansionare un sito per impedimenti oggettivi, giusto per fare un esempio, la causa non può che essere umana. Discorso simile legato ai problemi di sicurezza. Attività spesso trascurata, anche nella vita di tutti i giorni.

Analizzando la terza causa, Azioni manuali, invece, ci troviamo di fronte alla situazione in cui il motore “penalizza” il sito. Come si abusa dire in gergo.

Come nelle prime due cause, un’azione manuale è sempre da ricondurre alle attività umane che attuano le cosiddette strategie Black Hat. In pratica il gestore del sito mette in campo azioni che vanno contro le linee guida dei motori. Ad esempio un abuso di link building, cioè il classico io linko a te e tu linki a me nella speranza di manipolare i risultati dei motori.

La quarta causa individuata da Waisberg, riguarda il motore e gli aggiornamenti algoritmici che impattano i posizionamenti dei siti internet all’interno dei motori. Questi ultimi tendono sempre a migliorare la qualità dei risultati. Per farlo, implementano algoritmi che classificano le pagine web utilizzando diversi fattori.

Nel momento in cui un nuovo algoritmo inizia ad essere parte integrante della vita di un motore, alcuni siti potrebbero subirne le conseguenze. Sia in negativo che in positivo. Perché mentre alcuni siti perdono posizioni, altrettanti ne guadagnano. Un esempio recente è l’implementazione del nuovo fattore di ranking Esperienza sulle pagine web. I siti che non si sono adeguati ai nuovi standard, potrebbero subire cali di traffico dalla ricerca Google.

Infine, analizzando l’ultima delle cinque cause individuate da Daniel Waisberg, troviamo la perdita di interesse per un data ricerca.

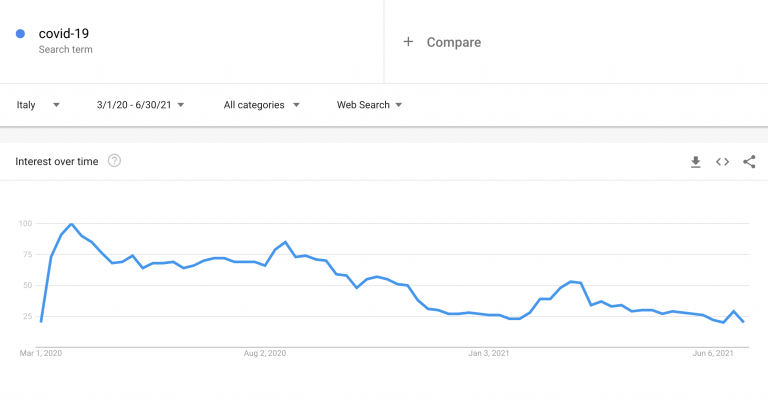

Prendiamo ad esempio il solo termine di ricerca “covid-19” in Italia. Secondo il servizio Google Trends, dal 1 marzo 2020 al 30 giugno 2021, dopo un ovvio picco raggiunto nelle prime settimane della pandemia e con il calare dell’emergenza, la stessa query viene cercata dagli utenti italiani molto meno che in passato.

Ragion per cui se un sito avesse trattato un tema specifico non più di tendenza, probabilmente si potrebbero verificare dei casi di calo di traffico.

Cali nella Ricerca Google: Le Responsabilità umane

Come abbiamo visto nei primi tre casi, la perdita di traffico può essere evitata lavorando in maniera etica, rispettando le linee guida fornite dai motori.

Avere un sito internet prestante dal punto di vista tecnico dovrebbe essere una priorità nei confronti degli utenti innanzitutto. Così come non trascurare la sicurezza della struttura web in generale.

Uno degli attacchi informatici più frequenti che coinvolge i siti internet è la cosiddetta iniezione di url. Si tratta di una attività che dopo aver preso possesso delle credenziali amministrative di un sito o della struttura che lo ospita, crea migliaia di url. Oppure, peggio, una volta che l’attaccante ha preso possesso di un sito, potrebbe rubare dati contenuti al suo interno. Come ad esempio i dati delle carte di credito degli utenti.

Evitare la nascita di problemi tecnici e di sicurezza, mette al riparo da eventuali azioni manuali. Cosi come mantenere un sito aggiornato secondo i moderni standard del web mette al riparo da eventuali scossoni causati da aggiornamenti algoritmici. Fermo restando che anche la qualità dei contenuti non deve essere trascurata.

Per approfondimenti: Analyzing Google Search traffic drops